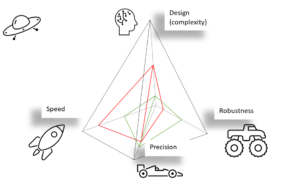

Abb. 1: Die vier Dimensionen eines guten Fahrzeugs. Das rote Volumen könnte ein Formel-1-Auto sein, während das grüne Volumen ein Rallye-Auto darstellen könnte.

von Jan Yorrick Dietrich

Haben Sie sich schon einmal gefragt, warum man nicht ein Fahrzeug haben kann, das gleichzeitig so schnell wie eine Rakete, so wendig wie ein Formel-1-Auto und so robust wie ein Monstertruck ist? Die Rakete mag blitzschnell sein, aber sie wird wahrscheinlich in engen Kurven versagen. Das Formel-1-Auto ist zwar recht schnell und wendig, geht aber wahrscheinlich ziemlich schnell kaputt, wenn es nicht vorsichtig auf Asphalt gefahren wird. Nun, und ein Monstertruck ist vielleicht sehr robust, aber im Vergleich dazu auch langsam. In vielen Forschungsbereichen stoßen die Wissenschaftler auf die gleichen Probleme wie oben beschrieben. Jede neue Entwicklung hat ihre Schattenseiten. Wenn man versucht, alle Bedürfnisse zu befriedigen, könnte man das wohl als eierlegende Wollmilchsau bezeichnen.

Das Fahrzeug meiner Träume sollte schnell, präzise, robust und schön anzusehen sein – und das alles auf einmal. Ein Rallyeauto ist ziemlich schnell, wenn auch langsamer als ein Formel-1-Auto oder eine Rakete. Sie sind beide ähnlich präzise, obwohl das Rallyeauto viel robuster ist als das Formel-1-Auto. Und schließlich gefällt mir persönlich das Design eines Formel-1-Autos viel besser. Das Fahrzeug meiner Träume könnte die graue Pyramide selbst ausfüllen und in jeder Dimension perfekt sein.

Weg von der Autoanalogie

Dieser Artikel soll sich mit den jüngsten Fortschritten und Zukunftsvisionen auf dem Gebiet der optischen Messverfahren und der künstlichen Intelligenz (KI) befassen. Wie passt das also zusammen?

Bevor ich hier ins Detail gehe, möchte ich sicherstellen, dass wir alle auf derselben Stufe stehen: Die Geschichte des Messens reicht 9000 Jahre zurück, als die ersten Völker die menschlichen Füße benutzten, um Entfernungen zu messen. Seitdem haben wir einen langen Weg zurückgelegt und nutzen nicht nur mechanische Messgeräte wie Lineale, sondern auch Messmethoden, die das Wissen der Physik und Chemie nutzen, um intelligente Messgeräte zu entwickeln. Kurz gesagt, eine optische Messung nutzt das Licht und seine Eigenschaften, um Abstände, Abweichungen und Unebenheiten zu messen, um nur einige wenige Beispiele zu nennen.

Wenn Sie eine komplexe Geometrie messen wollen, haben Sie es mit demselben Tetraeder von Prozessvariablen zu tun, das weiter oben in Abbildung 1 mit Schwerpunkt auf der Autoanalogie gezeigt wurde. Sie haben die Wahl zwischen mehreren Messmethoden, von denen einige extrem schnell und genau sind, aber empfindlich auf Vibrationen reagieren, während andere Technologien robust und genau sind, aber viel langsamer sind. Dies ist recht einfach zu verstehen, wenn man sich die Größenordnungen vor Augen führt, die dabei eine Rolle spielen. Einige optische Messgeräte sind bis auf Nanometer genau, was eine Million Mal kleiner ist als ein Millimeter. Eine Vibration in einer Produktionsumgebung wird vom menschlichen Körper vielleicht nicht erkannt, z. B. durch Berührung, aber das bedeutet nicht, dass sie nicht existiert – sie ist nur so klein, dass sie nur mit sehr empfindlichen Geräten erkannt werden kann.

Letztendlich begrenzen physikalische Prinzipien einige Technologien bei der Komplexität der Geometrie, die ein Objekt haben kann. Man kann sich das folgendermaßen vorstellen: Wenn ich ein Foto von Ihrem Hinterkopf mache, habe ich keine Ahnung, wie Ihr Gesicht aussieht – aber wenn Sie vor einem Spiegel stehen, kann ich vielleicht beides erahnen.

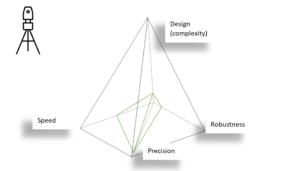

Abb. 2: Allgemeine Beschreibung optischer Messungen in vier Dimensionen. Das grüne Volumen könnte die Interferometrie darstellen.

Alle vier Dimensionen zusammen können dann mit dem Tetraeder der optischen Messtechnik dargestellt werden:

Das grüne Volumen in Abbildung 2 veranschaulicht das interferometrische Prinzip. Generell ist die Interferometrie sehr genau (gemessen in Nanometern), recht schnell (gemessen in Millisekunden), aber auch empfindlich gegenüber Erschütterungen. Diese können in der Regel in Laborumgebungen eliminiert werden, nicht aber in Produktionsprozessen. Daher könnte die Robustheit in einer nicht skalaren Dimension quantifiziert werden, die bei den Laborumgebungen in der Mitte des Tetraeders beginnt und sich zu den Produktionsumgebungen am Rand hin entwickelt. Schließlich ist die Interferometrie auch in Bezug auf das Design eines Objekts – die geometrische Komplexität – begrenzt.

Nun könnte man sich fragen, warum wir nicht alles auf einmal haben können. In Anbetracht der Analogie zum Auto mag Ihnen das trivial erscheinen, doch wenn man sich auf den Bereich der optischen Messung konzentriert, ergeben sich viele Ungewissheiten, je schneller, genauer oder belastbarer man messen muss. Messtechnologien werden oft durch die Physik der Quantenmechanik und die Regeln der Optik begrenzt – die Heisenbergsche Unschärferelation[1]ist eines dieser Phänomene.

Die neue Idee

Bisher neigen Ingenieure dazu, die Komponenten eines Systems einzeln zu optimieren, z. B. den Sensor oder die Recheneinheit, was das System zwar bis zu einem gewissen Grad verbessern kann, uns aber nicht erlaubt, ein System bis zu seinem vollen Potenzial zu optimieren. Traditionell benötigen Ingenieure für jede komplexe Messaufgabe eine Menge Erfahrung und Tests, da wir nicht in der Lage sind, das System auf einmal zu verbessern.

An dieser Stelle kommt COMet, Computational Optical Metrology, ins Spiel: Wissenschaftler der Universität Bremen entwickeln derzeit ein neues Verfahren, das künstliche Intelligenz einsetzt, um diese Messungen in ihrer Gesamtheit zu optimieren. Dabei kommt die Forschergruppe aus verschiedenen Forschungsbereichen, darunter Mathematiker, Physiker und Informatiker.

Um das COMet-Konzept zu verstehen, möchte ich Sie auf eine kurze Reise durch die Grundlagen der optischen Messungen entführen.

Was steckt dahinter?

Jedes herkömmliche Messsystem enthält einen Sensor, z. B. eine Kamera, die Informationen empfängt. Diese Informationen können anschließend von einem Computer analysiert werden, und die gewonnenen Daten können interpretiert werden. Diese Interpretation wird als “Lösung des inversen Problems” bezeichnet, da wir nur Wirkungen messen und damit die Ursachen erforschen können. Sie können sich das so vorstellen, wie wir Erdbeben (Auswirkungen) messen und analysieren, um mehr über die Ursachen im Inneren unseres Planeten zu erfahren.

Eine Art von Systemen, auf die sich das Team konzentrierte, um sie zu verbessern, sind interferometrische Messsysteme. Auch wenn das Wort selbst schwierig klingt, kennen Sie vielleicht sogar das Grundkonzept. In der Schule haben sie vielleicht gehört, dass Licht sowohl die Eigenschaften eines Teilchens (Photon) als auch die einer Welle haben kann. In mancher Hinsicht verhalten sich elektromagnetische Wellen sehr ähnlich wie Wasserwellen – sie können sich stapeln oder sogar auslöschen, wie das berühmte Doppelspaltexperiment zeigt, das in Video 1 demonstriert wird.

Video 1: Das Doppelspaltexperiment. Wenn man Teilchen auf einen Doppelspalt schießt, ordnen sie sich in einem Interferenzmuster an der Wand hinter dem Doppelspalt an. Dies kann erklärt werden, wenn (Licht-)Teilchen auch Eigenschaften einer Welle haben. Empfohlen bis 11:35 Min.

Die auftretenden Muster stellen eine bestimmte Superposition von zwei Wellen dar, was nichts anderes bedeutet, als dass sie sich überlagern. Um es einfach zu halten: Diese Messsysteme machen sich dieses Phänomen zunutze und können dadurch nahezu perfekt genaue Messungen liefern. Leider kann diese Methode nur Aufschluss über die Überlagerung zweier Wellen geben, aber nicht darüber, wie weit etwas absolut entfernt ist. Der Grund dafür ist, dass wir nur den Versatz zweier Wellenberge messen können (da wir die Wellenlänge unserer Messung kennen), indem wir die Muster analysieren, aber wir wissen nicht, wie viele Amplituden (Anzahl der Wellenberge) zwischen dem Sensor und dem Objekt liegen, das wir messen wollen. Diese Art von Problemen wird immer schwieriger vorstellbar, je tiefer wir in die Details optischer Messungen eindringen.

Glücklicherweise müssen wir nicht immer jedes Detail kennen. Zum Beispiel kann die Kenntnis des Versatzes manchmal schon alles sein, was man wissen will. Bei der Prüfung auf kleine Unebenheiten auf einer relativ flachen Oberfläche eines Produkts kann es völlig in Ordnung sein, den Fehler mit hoher Präzision zu kennen, da man nicht daran interessiert ist, wie weit die Oberfläche tatsächlich vom Sensor entfernt ist – man will nur die Rauheit der Oberfläche kennen. Selbst wenn unserer Messung also bestimmte Informationen fehlen, können wir mit den Ergebnissen sehr zufrieden sein. Letztendlich hat jede Messtechnik ihre eigenen Vor- und Nachteile.

Bis jetzt haben wir viel Theorie behandelt, deshalb möchte ich Ihnen im Folgenden einige Anwendungen aus der Praxis vorstellen.

Was Smartphones mit optischen Messungen zu tun haben

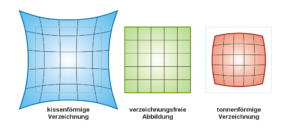

Eine weitere Möglichkeit, ein System zu optimieren, besteht darin, Kosten für Geräte einzusparen, insbesondere für teure Optiken. Werfen wir einen Blick auf unsere Smartphone-Kameras, denn sie sind ein weit verbreitetes optisches Messgerät für den täglichen Gebrauch. Die Hersteller bauen meist kleine (und billige) Optiken ein, die zu Bildfehlern führen, wenn sie nicht nachbearbeitet werden. Mit Hilfe von Computational Imaging können Bilder optimiert werden, indem die Entwickler den Smartphones beibringen, in welcher Weise die Kamera nicht ideal ist, um die Bildqualität zu verbessern. Man kann sich das so vorstellen, dass man einen Filter über sein Bild legt, der es besser aussehen lässt. Das Problem dabei ist: Diese “Filter” eignen sich nur für bestimmte Umgebungen und sind nicht für jede Lichtsituation etc. ideal, da sie sich nicht perfekt an diese anpassen können. Ein Beispiel dafür ist in Abbildung 3 dargestellt.

Abb. 3: Verzerrung von Bildern: Bei Fischaugenobjektiven ist das erwünscht, aber bei herkömmlichen Kameras müssen verzerrte Bilder durch mathematische Tricks korrigiert werden.

Wo der Zauber beginnt.

Bremer Forscher kamen auf die Idee, künstliche Intelligenz einzusetzen, um diese Idee auf die nächste Stufe zu bringen. Nachdem das COMet-System Informationen über die Messapparatur und das Messobjekt erhalten hat und die Daten abgerufen wurden, werden diese im Hinblick auf die Parameter des Messsystems analysiert. Diese Analyse führt zu neuen optimierten Parametern für die Messung, die dann an das System zurückgesendet werden. Die nächste Messung, bei der der neue optimierte Parametersatz angepasst wird, kann dann erneut analysiert werden. Dieser Zyklus kann mehrmals wiederholt werden, um das System bei jedem Durchlauf weiter zu optimieren.

Die Analyse aller Parameter kann gespeichert und in eine logische Sprache übersetzt werden, die von einer künstlichen Intelligenz verstanden und genutzt werden kann. Die archivierten Informationen können sogar zu verschiedenen Informationsgruppen kombiniert werden. Wissenschaftler nennen diesen Prozess Wissensrepräsentation und Reasoning. Je mehr Daten man schließlich einspeist, desto bessere und verlässlichere Prognosen und Optimierungen wird die KI mit Hilfe von Deep-Learning-Techniken erstellen.

Wenn alles so funktioniert, wie die Bremer Wissenschaftler denken, können sie sich Instrumente vorstellen, die in der Lage sind, neue Messungen (teilweise) mit wenigen Eingaben vollständig zu planen und durchzuführen.

Die Forscher fordern daher einen Paradigmenwechsel, ähnlich dem des Compressed Sensing, das Mitte der 2000er Jahre zu einer Vielzahl neuer Algorithmen führte und die Art und Weise, wie Daten abgerufen und verarbeitet werden, veränderte (bezogen auf die Autoanalogie könnte man auf den Paradigmenwechsel bei Wasserstoff-Brennstoffzellen und Elektromotoren, im Gegensatz zu Verbrennungsmotoren sprechen).

Einfach und unkompliziert

Zu Beginn dieses Artikels habe ich Ihnen das Fahrzeug meiner Träume vorgestellt, das vier Aspekte auf einmal erfüllen musste. Wir bekamen schnell ein Gefühl für die Probleme, auf die Wissenschaftler bei fast jeder neuen Entwicklung stoßen, die Tatsache, dass einige Dimensionen einfach im Widerspruch zu anderen stehen, und dass wir nicht alles auf einmal haben können.

Wenn wir den Sprung zur optischen Messtechnik machen, kann man meiner Meinung nach mit Sicherheit sagen, dass, wenn wir weiterhin die Leistung einzelner Komponenten untersuchen, weitere Verbesserungen ziemlich schnell zu einem Ende kommen werden. Die computergestützte optische Messtechnik steht erst am Anfang, obwohl wir uns vorstellen können, dass die Nutzung des Wissens über physikalische Prozesse und leistungsfähiger Werkzeuge wie Künstlicher Intelligenz und Compressed Sensing das Potenzial der Messungen von morgen in vielerlei Hinsicht verbessern wird, einschließlich der Kosten- und Zeitersparnis. In vielen Forschungsbereichen wurden Methoden der künstlichen Intelligenz bereits sehr effektiv eingesetzt, wobei die Spracherkennung eine der bekanntesten Anwendungen ist. Produkte wie “Alexa”, “Hey Google” und “Siri” würden nichts verstehen, wenn sie nicht die leistungsstarken Werkzeuge der KI nutzen würden. Auch das autonome Fahren ist ein Bereich der KI-Forschung. Wenn sie richtig eingesetzt werden, haben diese Systeme das Potenzial, die Fahrsicherheit in Kombination mit dem menschlichen Fahren erheblich zu verbessern. Die Bremer Forscher hoffen, ähnliche Synergien nutzen zu können, da nicht nur Forscher aus dem Bereich der Ingenieurwissenschaften und der Informatik, sondern auch Physiker und Mathematiker auf diesem neuen Forschungsgebiet zusammenarbeiten.

References

- The Heisenberg uncertainty principle, explained by The Guardian (Englisch) / Heisenberg unter dem Mikroskop(Deutsch)

- Bergmann, R B; Falldorf, C; Dekorsy, A; Bockelmann, C; Beetz, M; Fischer, A

Ganzheitliche optische Messtechnik

Quelle: Physik Journal 18, 2 (2019) 34-39 - https://de.wikipedia.org/wiki/Verzeichnung#/media/Datei:Verzeichnung3.png

Schreibe einen Kommentar