Wie wir mit unserem mechanischen Gegenüber sicher zusammenarbeiten können

von Artem Schurig

Abbildung 1: Einen vielseitigen und belastbaren Arbeitskollegen zu haben wie Chappie, das wäre doch stark oder? 1 © 2015 Columbia Pictures Industries, Inc., LSC Film Corporation and MRC II Distribution Company LP. All Rights Reserved

Abbildung 2: Schritt für Schritt in die Zukunft der Mensch-Roboter-Kollaboration. © anaterae auf Pixabay

Aktuell werden in der Industrie schwergewichtige und monotone Aufgaben von der klassischen Robotik erledigt, der Mensch wird dabei aus Sicherheitsgründen aus der Arbeitszelle ausgeschlossen. Doch kennt jeder aus Film und Büchern die fiktiven Roboter der Zukunft, die gemeinsam mit dem Menschen an ihrer Seite Aufgaben erledigen. Sind wir davon wirklich noch so weit entfernt, wie es auf den ersten Blick scheint? Noch sind humanoide Roboter, die sich wie Menschen eigenständig bewegen und intelligent agieren, eine ferne Fiktion. Dabei wird es jedoch vermutlich nicht bleiben. Mit sog. Mensch-Roboter-Kollaborationen (im Folgenden oft mit MRK abgekürzt) gehen Industrie und Wissenschaft nun erste wacklige Roboter-Schritte in Richtung dieser Vision2. Zum Teil lassen sie diese sogar schon zur Realität werden.

Können wir schon bald Hand in Hand mit unseren Roboterkollegen gehen und uns dabei nachdenklich entspannen, während sie die schwere und anstrengende Arbeit für uns erledigen? Eine Antwort auf diese Frage, sowie einen kleinen Ausblick erhältst du in diesem Artikel.

Menschen und Roboter als Team? – Eine Frage der Sicherheit

Abbildung 3: Aktuell sieht die Arbeit von Robotern und Menschen oft noch so aus – ihre Arbeitsplätze sind räumlich voneinander getrennt. © BIBA

Bei der Mensch-Roboter-Kollaboration arbeiten die Industrieroboter direkt mit dem Menschen zusammen, ganz ohne räumliche Trennung, wie beispielweise einem klassischen Sicherheitszaun. Dabei werden die Vorteile des Menschen als auch des Roboters ausgenutzt. Diese kollaborierenden Roboter oder auch Cobots genannt sind eine wesentliche Technologie der Industrie 4.0. Cobots spielen somit eine wichtige Rolle im aktuellen Fortschritt der Technik und auch der Forschung. Das Bremer Institut für Produktion und Logistik in Kooperation mit der Firma PUMACY Technologies betreibt an der Bremer Universität Forschung auf diesem Fachgebiet3. Klingt super!? Doch Vorsicht ist geboten! Der Roboter als schwere aber bewegliche Maschine, kann eine Gefahr für die menschlichen Teammitglieder darstellen. Um den Menschen vor Unfällen zu schützen, muss der Roboter zu jeder Zeit genau wissen, wo er sich befindet. Nun kommt man zu der simplen Frage:

Wie kann ein mechanischer Roboter Menschen wahrnehmen und erkennen? Und kann der Roboter in naher Zukunft menschlich werden oder bleibt es bei der Fiktion?

Die Antworten liefern uns sogenannte Cyber-Physische-Systeme, welche die Disziplinen Maschinenbau, Elektrotechnik und Informatik miteinander verbinden.

Aber was sind denn diese Cyber-Physischen-Systeme?

Wie man sich bereits denken kann, müssen diese Cyber-Physische-Systeme etwas mit Datenverarbeitung zu tun haben, da das Wort Cyber darin vorkommt. Es ist also eine virtuelle Komponente enthalten. Weiterhin muss es durch den physischen Teil etwas Anfassbares enthalten. Als System müssen diese beiden Komponenten zusammenarbeiten.

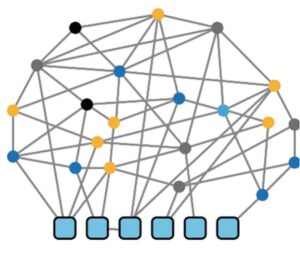

Abbildung 4: Schematische Darstellung der Netzarchitektur eines Cyber-Physischen-Systems. Das Netzwerk verbindet Sensoren und Aktoren (bunte Punkte) mit dem „Gehirn“ – den eingebetteten Systemen (blaue Kästchen).4

Diese Annahmen sind tatsächlich korrekt, denn Cyber-Physische-Systeme oder auch in Kurzform CPS genannt, sind vernetzte und kommunikationsfähige Komponenten, welche eingebettete Systeme enthalten. Nun, Komponenten und eingebettete Systeme – klingt kompliziert? Ist es eigentlich gar nicht! Das Ganze hat eine sehr große Ähnlichkeit mit dem menschlichen Gehirn, deren Nervenbahnen, den Nervenenden und der Muskulatur. Diese eingebetteten Systeme stellen dabei das Betriebssystem der Komponenten und somit das Gehirn und deren Logik dar. Das physische Objekt kann dabei ein Roboter, ein Verkehrsmittel oder sogar ein ganzes Gebäude sein. Es nimmt also primär die Rolle der Muskulatur und somit des Aktors ein. Viele dieser physischen Objekte sind miteinander über Netzwerke wie das Internet vernetzt und lassen sich damit steuern, regeln und kontrollieren. Die bunten Punkte in Abbildung 4, stellen die Sensorik und Aktorik dar, die blauen Kästchen sind die Geräte mit den eingebetteten Systemen und die Verbindungslinien bilden das Netzwerk unter den vielen einzelnen Knotenpunkten.

Mithilfe von Sensorik werden Umgebungsdaten aus der physischen Umwelt aufgenommen. Die gesammelten Daten werden dann durch das Netzwerk an die eingebetteten Systeme weitergeleitet. Die darauf laufende Software verarbeitet diese Daten weiter und löst mithilfe der Steuerdaten eine Reaktion des Aktors aus, ähnlich dem Gehirn des Menschen, welches beispielsweise bei einer Schmerzempfindung die Rückziehung der Hand auslöst.

Welche Sensorsysteme gibt es? Und wie genau kann ein Roboter damit den Menschen erkennen?

Abbildung 5: Physische Annäherungen von Menschen und Robotern müssen vorsichtig gestaltet werden. Dazu braucht es sensible und verlässliche Sensorsysteme, die dem Roboter zu jeder Zeit eindeutig mitteilen, wo sich sein Gegenüber gerade befindet – im Zweifelsfall bis zum kleinen Finger. © Tumisu auf Pixabay

Sensorsysteme sind heutzutage sehr intelligent und bestehen aus einer Vielzahl von oftmals autarken Sensoren. Diese übertragen und kombinieren die erfassten Daten zentral ein der Auswerteinheit, welche die nötigen Auswertungen an die Zentrale des gesamten Cyber-Physischen-Systems übermittelt. In der deutschen Norm für Sicherheitsanforderungen für Industrieroboter (ISO 10218-1) sind vier Typen der Mensch-Roboter-Kollaboration festgelegt. Dabei hat sich die kontinuierliche Geschwindigkeits- und Abstandüberwachung als die praktikabelste Methode erwiesen. Deshalb werden im Folgenden die bekanntesten und bewährtesten Sensorsysteme beschrieben, die eine kontinuierliche Geschwindigkeits- und Abstandüberwachung sicherstellen, bei welcher der Mensch den Kollaborationsraum betreten darf.

1. Wer braucht Ultra-HD? Wir nutzen “Ultra-Funk”!

Die in MRK-Sensorsystemen am meisten verwendete Technologie ist Ultra-wideband (Ultra-Breitband) oder auch kurz UWB genannt. Bei Ultra-wideband handelt es sich um eine Funktechnologie zur Nahbereichskommunikation, welche dem bekannteren WLAN-Funk sehr ähnelt. Die UWB-Technologie nutzt einen besonders breiten Frequenzbereich von 3,1 bis 10,6 GHz und begrenzt die Signalleistung auf sehr geringe 10 nW. Durch die Verteilung auf ein großes Frequenzband werden Störungen zwischen Ultra-wideband und anderen Funktechnologien vermieden und so die Nutzung bereits belegter Frequenzbänder ermöglicht.

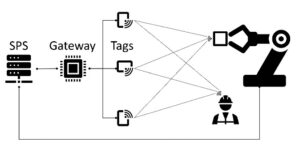

Abbildung 6: Prinzipieller Aufbau eines Echtzeitortungssystems mit Ultra-wideband. Eigene Zeichnung

Nun, wie trägt diese Funktechnologie denn genau zur Ortung des Menschen bei, damit der Roboter diesen erkennen kann? Hierfür wird das sogenannte Ultra-wideband-Real-Time-Location-System oder auch kurz UWB-RTLS. Dabei handelt es sich um ein Echtzeitortungssystem welches aus Tags, Anchors und einem Gateway besteht, welches man in Abbildung 6 sehen kann. Die Tags werden an dem zu lokalisierenden Menschen oder anderen mobilen Objekten angebracht. Bei den Anchors handelt es sich um Antennen, die an festen Positionen aufgestellt werden und am Gateway angeschlossen werden. Diese dienen als Referenzpunkte für die Tags. Die Positionskalkulation erfolgt durch das Gateway, das an die Speicherprogrammierbare Steuerung des darüberstehenden Cyber-Physischen-Systems gekoppelt ist. Die Positionsbestimmung erfolgt in der Regel nach dem Laufzeitverfahren.

2. Jetzt kommt Hollywood-Technologie ins Spiel!

Abbildung 7: Künstlerische Darstellung von Neytiri aus dem Film Avatar. Diese Filmfigur wurde auch mithilfe eines Motion-Capture-Systems gespielt und animiert. © moonsword auf Pixabay

Eine weitere interessante Technologie in der Mensch-Roboter-Kollaboration bieten die sogenannten Inertialen-Messeinheit-Sensoren (engl. Inertial-Measuring-Unit) oder kurz auch IMU genannt. Ein solcher Sensor fusioniert dabei wiederum einzelne Sensoren wie Beschleunigungsmesser, Gyroskop (Kreiselinstrument zur Messung der Rotationsgeschwindigkeit) und Magnetometer auf einer winzigen Platine von der Größe einer 1 Euro Münze. Mit dessen Hilfe erhält man Daten wie die Beschleunigung, die Winkelgeschwindigkeit und Orientierung des Sensors. Für die Mensch-Roboter-Kollaboration werden viele dieser Sensoren in Kleidung integriert, wodurch sich ein Motion-Capture-System zur Bewegungserkennung ergibt. Ein bekanntes System ist der Perception Neuron Anzug der Firma Noitom. Solche Motion-Capture-Anzüge werden unter anderem auch von der Filmindustrie für Special Effects und Animation verwendet, wie z.B. bei Gollum aus Herr der Ringe, der Hulk, Neytiri aus Avatar oder TED. Dabei wird die reale menschliche Bewegung aufgenommen und später durch ein virtuell animiertes Modell überlagert. In der Mensch-Roboter-Kollaboration werden hingegen die Daten in Echtzeit aufgenommen und über Funk an die zentrale Recheneinheit übermittelt. Da die Roboterposition aus dessen Steuerung bekannt ist und das System mithilfe des Motion-Capture-Anzugs die Position des Menschen kennt, kann das Cyber-Physische-System den Abstand durch die Euklidische Distanz berechnen5. Wird eine kritische Distanz unterschritten, so wird der Roboter langsamer, bis dieser bei Kontakt komplett anhält. Begibt sich der Mensch wieder in eine sichere Entfernung, so nimmt der Roboter seine Arbeit wieder auf.

3. Wie wär’s mit Laserschwertern?

Abbildung 8: Nein, Laserschwerter sind natürlich aus naturwissenschaftlicher Sicht Quatsch, dennoch kann mit Licht und insbesondere Laserstrahlen beeindruckende Dinge angestellt werden. Mit 2D-Laserscannern kann bspw. die Position eines Menschen im Raum bestimmt werden. © Mario Eppinger auf Pixabay

Die letzte hier vorgestellte Variante ist das Nutzen von klassischer mittelbarer Sicherheitstechnik, wie Kameras und 2D-Laserscanner. Durch eine geeignete Anordnung dieser und einer smarten Steuerungs-Software ist eine sichere Mensch-Roboter-Kollaboration möglich. Die 2D-Laserscanner lokalisieren den Menschen in der Nähe des Roboters und geben die Position der Beine zurück. Die Kameras erkennen die Haltung des Menschen und erstellen mit diesen Daten ein Computermodell, welches dann auf dem von den 2D-Laserscannern erkanntem Punkt platziert wird. Mit diesen Daten wird analog zum Motion-Capture-Anzug der Abstand berechnet. Aus den hier vorgestellten Möglichkeiten ist diese Variante die nachhaltigste, da sich hierfür auch ältere Sensoren eignen und keine neuen angeschafft werden müssen. Lediglich die Software und die Anordnung der Sensoren muss oftmals verändert werden.

Das klingt alles super! Gibt es denn auch Hürden oder Einschränkungen?

Abbildung 9: Eine sehr sensible Frage für Arbeitnehmende – der Datenschutz. Außer dem Roboter sollte niemand Zugriff auf die sensiblen Bewegungsdaten haben. © geralt auf Pixabay

Bei dem Einsatz von Sensorsystemen zur Lokalisierung von Menschen können persönliche Daten wie beispielsweise das individuelle Arbeitsverhalten oder der Gesundheitszustand erfasst werden. Deshalb besteht im Betrieb die Notwendigkeit eines strengen Datenschutzes, um die Anonymität der Nutzenden zu gewährleisten. Abhängig vom genutzten Lokalisierungsverfahren und der Einsatzfläche wird eine Vielzahl an unterschiedlicher Hardware benötigt. Hierbei kann bei unzureichender Abwägung des Kosten-Nutzen-Verhältnisses das Gesamtsystem sehr teuer werden und den Gesamtnutzen der MRK-Lösung deutlich übersteigen.

Neben den finanziellen und organisatorischen Kosten ist die soziale Akzeptanz der Mitarbeitenden für ein solches Sensorsystem ein wichtiger Punkt. Durch die Forschung und Entwicklung im Bereich der Mensch-Roboter-Kollaboration werden immer günstigere, weniger komplexe und weniger auffällige Lösungen entwickelt, wodurch sich die Hemmschwellen für neue Automatisierungslösungen auf allen betrieblichen Ebenen senken lassen.

Also, aus Fiktion könnte Wirklichkeit werden

Wir haben also erfahren, dass auf dem Weg zu einem humanoiden Roboter noch viele Schwierigkeiten zu meistern sind. Noch bleiben Roboter wie Chappie also Science-Fiction Filmen vorbehalten. Doch mit Mensch-Roboter-Kollaborationen kommt die Forschung der Fiktion immer näher. Sicherheit ist dabei ein wichtiges Thema. Durch verbesserte Sensorik soll diese zukünftig ermöglicht werden.

Interesse an der Mensch-Roboter-Kollaboration geweckt?

Abbildung 10: Das Bremer Institut für Produktion und Logistik BIBA befindet sich direkt auf dem Campus der Uni Bremen. © Jens Lehmkühler / BIBA

Weitere Inhalte und Informationen zu den Intelligenten Sensorsystemen für die Mensch-Roboter-Kollaboration im Rahmen der Industrie 4.0 findest du am BIBA – dem Bremer Institut für Produktion und Logistik an der Universität Bremen.

Quellen

(1) https://www.filmtoast.de/chappie/

(2) https://www.iks.fraunhofer.de/de/themen/industrie-40/mensch-roboter-kollaboration.html

(3) https://www.biba.uni-bremen.de/presse/pressemitteilungen/2019.html

(4) https://link.springer.com/referenceworkentry/10.1007%2F978-3-642-35950-7_16790-15

Dieser Artikel hat viele meiner Fragen zum Thema “Roboter als Teammitglieder” beantwortet. Ich habe den Artikel sehr gerne gelesen und interessante Ideen daraus schöpfen können. Macht weiter so und schreibt interessante Artikel über Top-Themen.