Von Pia Götz

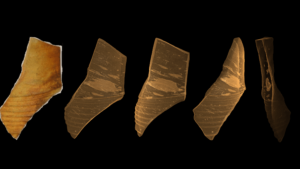

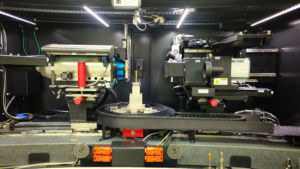

Abbildung 0: Mikro-CT-Bilder von Siegburger Steinzeug aus verschiedenen Perspektiven. © Pia Götz

Was haben ein Bänderriss im Sprunggelenk und eine Luftblase in einer Scherbe aus dem 16. Jahrhundert gemeinsam? Beides lässt sich zerstörungsfrei feststellen und vermessen. Mit einem Computertomographen.

Abbildung 1: Anatomische Zeichnung von Leonardo da Vinci. © WikiImages auf Pixabay

Den Begriff Computertomographen haben wir alle schon mal gehört. Einige haben vielleicht sogar schon selbst Bekanntschaft mit ihm gemacht. Mithilfe der Computertomographie (kurz: CT) können in der Medizin detaillierte Bilder aufgenommen und kleinste Veränderungen des menschlichen Gewebes sichtbar gemacht werden. Vor allem in der Diagnostik des Skelettsystems, des Gehirns und innerer Organe und Blutgefäße findet es Anwendung. Mediziner*innen erlangen so einen Einblick ins Innere des Körpers, ohne diesen öffnen zu müssen. Ein klarer Vorteil gegenüber alter Methoden, die wir uns rückblickend z. B. auf das frühe 16. Jahrhundert lieber nicht vorstellen möchten. Leonardo da Vincis detailgetreue- anatomischen Zeichnungen, zum Beispiel, sollen zum Teil auf selbst durchgeführten Sektionen basieren. Hätte es nur damals schon die Computertomographie gegeben.

Aber halt – Was genau hat das alles mit einer Scherbe zu tun?

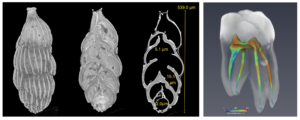

Die Technik, ursprünglich für den medizinischen Einsatz entwickelt, findet heutzutage auch in Wissenschaften außerhalb der Medizin ihren Nutzen, beim MAPEX Center for Materials and Processes an der Uni Bremen zum Beispiel. Hier werden Objekte aus unterschiedlichen Materialien mit einem Röntgenmikroskop untersucht. Von winzig kleinen Foraminiferen (siehe Abbildung 2, links), über Faser- und Gesteinsproben bis hin zu Zähnen (siehe Abbildung 2, rechts). Und eben auch eine Scherbe aus dem 16. Jahrhundert. Anhand dieser Scherbe wird in diesem Artikel die Computertomographie in der Materialwissenschaft erläutert.

Abbildung 2: Beispiel Foraminifere von links: 3D-Ansicht, virtueller Schnitt und CT-Bildscheibe. Rechts Zahn mit Dickenmessung der Wurzelkanäle. © MAPEX Wolf-Achim Kahl

Geschichte der Computertomographie

Seit der Entdeckung der Röntgenstrahlung am 8. November 1895 von dem deutschen Physiker Wilhelm Conrad Röntgen können wir Menschen uns elektromagnetische Wellen zu Nutze machen, um den Körper und andere Objekte zu durchleuchten.

Dabei wird das Absorptionsverhalten der unterschiedlichen Materialien genutzt. Dieses beruht zum Einen auf der Dichte des zu untersuchenden Objekts und zum Anderen auf der Zusammensetzung der chemischen Elemente. „Schwerere” Elemente mit einer hohen Ordnungszahl, sprich einer hohen Anzahl von Protonen im Atomkern, sind für Röntgenstrahlung eher undurchlässig, während „leichtere” Elemente die Strahlung kaum absorbieren. Das in den Knochen vorkommende Element Calcium, beispielsweise, hat mit einer Ordnungszahl von 20 deutlich mehr Protonen als das Element Wasserstoff mit der Ordnungszahl 1. Auch die anderen Elemente im weichen Gewebe, wie Kohlenstoff, Stickstoff und Sauerstoff weisen eine geringere Ordnungszahl, als die des Calciums auf. Unterschiedlich dichtes Gewebe absorbiert somit die Strahlung unterschiedlich stark, sodass dahinter ein Schattenbild entsteht. Zunächst auf zweidimensionalen Platten.

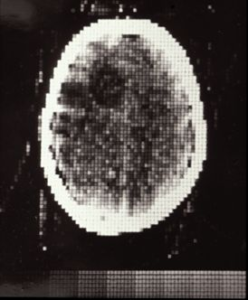

Abbildung 3: 1971: Weltweit erster CT-Scan eines Kopfes im Atkinson Morley Krankenhaus in London. In einer 80×80 Matrix. Jeder Scan dauerte pro Position 5 Minuten. © Atkinson Morley Krankenhaus

Erst über ein halbes Jahrhundert später, in 1971, wurde der erste Prototyp eines CT-Scanners vorgestellt. Zwar gab es vorher schon Überlegungen, Objekte aus verschiedenen Winkeln aufzunehmen, doch machte das fehlende Wissen über das Vorgehen bei der Rückrechnung der einzelnen Bilder die Umsetzung unmöglich. Zudem war die Wissenschaftscommunity damals noch nicht gut vernetzt. So arbeiteten der südafrikanisch-US-amerikanischer Physiker Allan McLeod Cormack in Massachusetts und der britische Elektrotechniker Sir Godfrey Newbold Hounsfield in England nahezu zeitgleich an derselben Fragestellung zur Rückrechnung und Rekonstruierung von Röntgenbildern.

Cormack arbeitete bereits in den 1950er Jahren an den mathematischen Herausforderungen der Rekonstruktion. Schon vor dieser Zeit hatte der österreichische Mathematiker Johann Radon im Jahre 1917 einen Meilenstein für zukünftige Generationen zurechtgelegt. Er konnte mit seiner Idee, der Radon Transformation, mathematisch zeigen, dass eine Funktion von unendlich vielen Projektionen der Funktion rekonstruiert werden kann. Nur wusste Cormack nichts davon. Er gab später an, erst 1972 von Radons Arbeit erfahren zu haben, sodass er sich selbst die Lösung habe suchen müssen.

Das Prinzip der Radon Transformation und die 1937 entwickelte Näherungslösung für große Systeme linearer algebraischer Gleichungen, durch den polnischen Mathematiker Stefan Kaczmarz, sind wichtige Bausteine Cormacks theoretischer Berechnungen. Allerdings fehlten ihm zu der Zeit die Apparaturen sowie ein Computer, um seine Ideen konkret umsetzen zu können.

So realisierte 1969 eine andere Person, die mit den notwendigen finanziellen Mitteln ausgestattet war, den ersten Prototypen eines CT-Scanners. Hounsfield war als Elektrotechniker bei EMI – ja, genau Electric and Musical Industries Ltd. – angestellt. Lange Zeit eines der größten Plattenlabels der Welt. Es hält sich bis heute das Gerücht, die Beatles, damals unter Vertrag bei EMI, hätten mit ihrem eingespielten Geld einen erheblichen Beitrag zur Entwicklung der Computertomographie beigetragen. An finanziellen Mitteln mangelte es EMI jedenfalls nicht. Allerdings hatte Hounsfield seinerseits, über die Vorarbeiten Cormacks keine Kenntnis und erarbeitete sich die Algorithmen für die Bildrekonstruktion aufwendig selbst.

Beide Wissenschaftler, der eine in den USA, der andere in England, teilen sich somit neben der Leidenschaft für die Computertomographie, zwei Gemeinsamkeiten:

- Beide hätten sich sehr viel Zeit und Arbeit sparen können, wären Publikationen damals schon in einer Online-Suche zu finden gewesen.

- Beide teilen sich 1979 den Nobelpreis für Physiologie und Medizin.

Ende gut, alles gut.

Die Entstehung einer digitalen Scherbe im 21. Jahrhundert

Die Scherbe aus dem frühen 16. Jahrhundert, jener Zeit, in der da Vinci für seine Aufzeichnungen noch sezierte, wird, wie in der schematischen Darstellung in Abbildung 4 gezeigt, auf einem rotierbaren Teller platziert. Denn anders, als wir es aus den Krankenhäusern kennen, rotieren hier Röntgenquelle und Detektor nicht um das zu untersuchende Körperteil, sondern die Scherbe dreht sich um die eigene Achse, während Röntgenquelle und Detektor fest an ihren Positionen verharren.

Figure 4: Röntgenmikroskop am MAPEX, von links: Röntgenquelle, rotierbarer Probenhalter, verschiedene Detektoren. © Pia Götz

Die Röntgenquelle, links der Scherbe, erzeugt Röntgenstrahlung. Der Detektor, rechts der Scherbe, misst dabei die Intensitäten der Strahlung, nachdem diese das Objekt durchquerte und wandelt sie erst in sichtbares Licht und dann mit einer Fotodiode in Elektronen um. Die Abstände der einzelnen Messpunkte auf dem Detektor legen die Pixelgröße und die räumliche Auflösung fest. Alle Pixel einer Aufnahme werden zu einem 2D Gesamtbild, auch Projektion genannt, zusammengesetzt. Dabei werden die Intensitäten für jedes Pixel als Grauwerte dargestellt, sodass ein schwarz-weiß Bild entsteht. Je undurchsichtiger eine Stelle im Objekt, desto höher die Abschwächung der Ausgangsstrahlung, desto geringer die Strahlung, die der Detektor an der Stelle wahrnimmt.

Abbildung 5: Wie aus einer analogen Scherbe ein digitales Objekt entsteht: Die Röntgenquelle erzeugt Röntgenstrahlung, welche die Scherbe passiert. Projektion wird durch Detektor aufgenommen. Der Teller dreht sich, die Scherbe wird aus einem anderen Winkel bestrahlt und gemessen. Mittels Algorithmus werden alle Projektionen zum Bilderstapel umgerechnet. Dieser Bilderstapel, bestehend aus vielen Schichten, wird zur weiteren Bearbeitung und Analyse in eine Software geladen. © Pia Götz

Nach jeder einzelnen Messung dreht sich der Teller mit der Scherbe um ein Zehntel Grad weiter, bis das Objekt einmal komplett vermessen wurde. So entstehen rund 2.000 Röntgenaufnahmen aus verschiedenen Blickwinkeln. In der Regel reichen 180° als Drehung aus, da alles über 180° bereits gemessen wurde, nur von der anderen Seite.

Die Rekonstruktion – Projektionen werden zu Scheiben

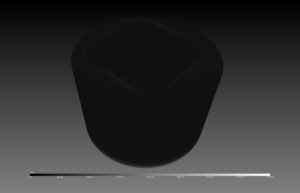

Abbildung 6: Bilderstapel als 3D-Objekt. Luft mit geringen Grauwerten wird zunächst schwarz angezeigt, Rand des Kunststoffbehälters erkennbar. © Pia Götz

Die Projektionen unter den verschiedenen Blickwinkeln werden dann mittels eines Algorithmus´ zu einem 3D-Objekt zurückgerechnet. Das Ergebnis wird als Rekonstruktion bezeichnet. Dazu benötigt werden zu den gemessenen Intensitäten unter anderem auch die Geometrie des Messaufbaus, also wie weit waren Röntgenquelle, Objekt und Detektor jeweils voneinander entfernt. Nach der sogenannten Rückprojektion liegt unsere Beispiel-Scherbe aus dem 16. Jahrhundert nun als Grauwert-Bilderstapel einzelner Scheiben vor. Virtuelle Schnitte durch das Objekt also. Hier erklärt sich auch der Begriff Tomographie. So bedeutet τομή, tome im Altgriechischen ‚Schnitt‘ und γράφειν, graphein ‚schreiben‘.

Eine Tonscherbe ganz groß

Die Vermessung einer Scherbe kann durchaus einige Stunden in Anspruch nehmen, abhängig von Größe und gewünschter Auflösung. Auch die Rekonstruktion benötigt viel Zeit und zudem eine enorme Rechenleistung. So können die einzelnen Projektionen einer kleinen Scherbe bis zu 20 GB Platz einnehmen. Zum Vergleich, der Film Matrix nimmt mit seinen 2 Stunden 16 Minuten in der Version 4K Ultra HD weniger Platz auf der Festplatte ein.

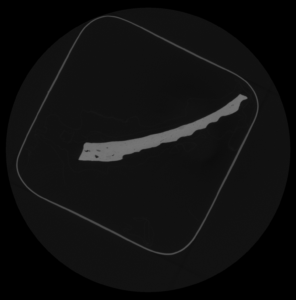

65.536 shades of grey

Liegt das einst analoge Objekt nun in digitaler Scheibchenform auf der Festplatte, kann es in ein Grafikprogramm geladen werden. Doch was passiert dann? Die Bildpixel werden nun zu volumetrischen Pixeln, auch “Voxel” genannt, und zunächst als ein massiver, grauer Block dargestellt. Denn auch alles, was wir als Nicht-Scherbe definieren, aber in das Messvolumen fällt, wird generell mitgemessen. So auch die Luft, der Behälter, in dem sich die Scherbe befindet und das Polstermaterial, das die Scherbe während des gesamten Messvorgangs vor dem Verrutschen schützt. Der Computer kennt also erstmal keinen Unterschied zwischen den unterschiedlichen Materialien. Schwarz und Weiß mit all den 65.534 Nuancen dazwischen werden angezeigt.

Abbildung 7: Grauwertscheibe der Scherbe im Kunststoffbehälter mit Papier zur Polsterung, Pixelwerte liegen zwischen 0 (schwarz) und 65.535 (weiß). © Pia Götz

Erst durch das Ausblenden eines bestimmten Wertebereichs der Grauwerte, werden Eigenschaften sichtbar, die vorher versteckt waren. Blenden wir nun einmal virtuell die Luft aus, sehen wir die Scherbe in ihrem Papiernest in einem Plastikbehälter, so wie sie während des Messvorgangs im Gerät gebettet war. Für die weitere Bearbeitung ist es von Vorteil, das Bildvolumen zu verringern. Daher erfolgt eine Segmentierung: Die Grauwerte, die von Interesse sind, d.h. die der Scherbe, werden markiert. Der umliegende Rest wird entfernt. Somit schrumpft das Bildvolumen erheblich.

Abbildung 8: 3D der Scherbe im Kunststoffbehälter mit semitransparenter Luft und Polsterung. Unten: Segmentierung des Grauwertbereichs der Scherbe. © Pia Götz

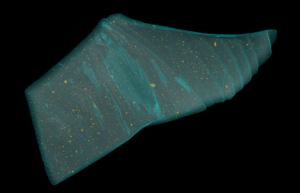

Aus grau wird bunt

Wollen wir nun noch weiter in das Innere der Scherbe schauen, also ihre inneren (Grau-)Werte betrachten, können sorgfältig ausgesuchte Wertebereiche nicht nur aus- oder eingeblendet, sondern auch farblich markiert werden. Zudem können Kontrasteinstellungen bei der Visualisierung hilfreich sein. Wir betreten nun den virtuellen Bereich des Renderings. To render something bedeutet so viel wie etwas wiedergeben oder vorlegen. Es ist das Zusammenspiel aus Licht und Schatten in einer animierten Filmszene. Auch bei der Visualisierung von Computerspielen findet es Anwendung. Es entsteht ein virtuelles räumliches Modell, das auf Basis von Rohdaten die Blickrichtung des Betrachtenden, Lichteffekte und Schärfentiefeneffekte künstlerisch erstellt.

Abbildung 9: Semitransparente Darstellung der Scherbe. Durch Rendern werden Lufteinschlüsse sichtbar. Partikel mit höherer Röntgenabsorption sind gelb markiert. © Pia Götz

Folglich können Farbe und Materialeigenschaften, wie Spiegelungen auf der Oberfläche, völlig losgelöst vom analogen Objekt, beliebig verändert werden. So werden auch Lufteinschlüsse in der Scherbe digital sichtbar gemacht, wenn die Transparenz des umliegenden Materials erhöht wird. Die Form und Verteilung dieser Lufteinschlüsse lässt Rückschlüsse auf die Herstellungsmethoden zur damaligen Zeit zu. Auch die Zusammensetzung des Materials kann auf ähnliche Weise beurteilt werden. Schauen wir uns nur mal die gelben Partikel in der Abbildung an. Dies sind Bereiche, die einen höheren Grauwert aufweisen. Das Material ist hier also für die Röntgenstrahlung undurchlässiger als das umliegende Material. Was könnte die Ursache hierfür sein? Welche weiteren Auffälligkeiten können wir erkennen? Welche materialwissenschaftliche Erkenntnisse ziehen wir daraus und welchen Nutzen hat das Rendering für andere Wissenschaftsdisziplinen? Bald folgt ein weiterer Science Blog Artikel, der auf Zeitreise geht, um genau diese und weitere spannende Fragen zu beantworten.

Quellen

Geschichte der Computertomographie:

Seynaeve PC, Broos JI. [The history of tomography]. J Belge Radiol. 1995 Oct;78(5) 284-288. PMID: 8550391.

https://en.wikipedia.org/wiki/History_of_computed_tomography

Bildquellen

Erster CT-Scan eines Kopfes – http://www.impactscan.org/CThistory.htm

Beispielbilder Foraminifere und Zahn: Wolf-Achim Kahl, MAPEX Bremen, wakahl@uni-bremen.de

Alle anderen Visualisierungen: Pia Götz, MAPEX Bremen, piagoetz@uni-bremen.de

Visualisierungssoftware: Dragonfly ORS 2021.3 – https://www.theobjects.com/index.html

Schreibe einen Kommentar