von Elisa Brauße

Der (Astro-)Physiker Stephen Hawking, wahrscheinlich der bekannteste Mensch mit Amyotropher Lateralsklerose (ALS, siehe Infobox), verlor nach einem operativen Eingriff seine Sprechfähigkeit komplett. Solange er seine Hände noch bewegen konnte, wählte er mithilfe eines Sprachcomputers Buchstaben, Wörter oder ganze Satzteile aus einer Datenbank aus, die der Computer dann für ihn „aussprach“. Als er auch seine Hand nicht mehr kontrollieren konnte, steuerte er seinen Sprachcomputer stattdessen mit einem Infrarot-Sensor, der die Muskelaktivität in seiner Wange registrierte. [1]

Spätestens seit der Ice Bucket Challenge und dem Film „Die Entdeckung der Unendlichkeit“ dürfte den meisten die Krankheit Amyotrophe Lateralsklerose, besser bekannt unter der Abkürzung ALS, ein Begriff sein. ALS bezeichnet den schrittweisen Verlust von Neuronen, die Signale an Muskeln senden. Dieser führt zu immer ausgeprägteren Lähmungserscheinungen bis hin zum Verlust der Sprach- und letztendlich auch der Atemfähigkeit.

Obwohl seine Wangensteuerung ihm immer die liebste blieb, experimentierte Hawking auch mit anderen Technologien, wie zum Beispiel der Steuerung seines Sprachcomputers mithilfe von Gehirnaktivität. Denn Ansätze dazu gibt es schon lange. Sie werden Gehirn-Computer-Schnittstellen genannt, im Englischen Brain-Computer Interfaces (BCIs). Hinter diesem Begriff stehen verschiedene Methoden mit etlichen Anwendungsbereichen. Dazu gehören neben dem Buchstabieren die Steuerung von Prothesen und Rollstühlen, das Navigieren eines Cursors auf dem Bildschirm und vieles mehr.

In diesem Artikel bleiben wir allerdings bei Sprachsystemen, die Menschen das Kommunizieren vereinfachen oder überhaupt erst ermöglichen sollen. Denn es sind nicht nur ALS-PatientInnen, denen solch eine Technik helfen kann. Auch beispielsweise nach Schlaganfällen in bestimmten Hirnregionen kann eine fast vollständige (engl: locked-in-syndrome (LIS)) oder vollständige Lähmung (engl: completely LIS (CLIS)) eintreten, aufgrund derer PatientInnen sich nicht bemerkbar machen können (deutsch: Gefangenheitssyndrom).

Um diesen PatientInnen-Gruppen Kommunikation zu ermöglichen wird an entsprechenden mobilen Techniken und Methoden geforscht. Eine Technik, die in den allermeisten Ansätzen genutzt wird, ist das EEG (Elektroenzephalographie). Dabei wird mit Elektroden, die mit einer Kappe auf dem Kopf befestigt werden, die elektrische Aktivität der Nervenzellen in der äußeren Schicht des Gehirns (dem Kortex, deutsch: Großhirnrinde) gemessen. Aber während die Messtechnik in vielen Fällen dieselbe ist, sind die verwendeten EEG-Signale und Auswertungsmethoden vielfältig.

Signale, die früh als hilfreich erkannt wurden und immer noch oft zu Hilfe genommen werden, sind Ereigniskorrelierte Potenziale (EKPs), die, wie ihr Name schon verrät, in Verbindung mit einem bestimmten Ereignis stehen. Eins der deutlichsten und deshalb am häufigsten verwendeten EKPs ist das sogenannte P300: P kennzeichnet einen positiven Ausschlag im EEG, 300 gibt die ungefähre Zeit des Auftretens des EKPs nach dem Ereignis an (in Millisekunden). Das P300 tritt grob gesagt immer dann auf, wenn das Gehirn einen besonderen Reiz entdeckt: zum Beispiel wenn in einer Serie von gleichen, hohen Tönen plötzlich ein tiefer Ton auftaucht. [3] Oder wenn ihr in einer Sequenz auf einen für euch wichtigen Reiz achtet. Stellt euch zum Beispiel vor, ihr wollt ein ‚M‘ schreiben. Wenn euch dann nacheinander jeder Buchstabe des Alphabets gezeigt wird, wird euer Gehirn auf das für euch relevante ‚M‘ anders reagieren als auf die vielen anderen, unwichtigen Buchstaben. Und dieses Signal lässt sich mit dem EEG aufnehmen. Leider müssen sogar beim P300 etliche Wiederholungen durchlaufen werden, um das EKP herauszufiltern, obwohl es eins der stärksten EKPs ist.

Da diese Methode sehr lange brauchen würde, um einen Buchstaben auszuwählen, wurde die Raster-Methode entwickelt. Dabei wird dem/der NutzerIn immer eine ganze Reihe von Buchstaben nach der anderen, dann eine ganze Spalte nach der anderen gezeigt. Jedes Mal, wenn die präsentierte Reihe oder Spalte den gewünschten Buchstaben enthält, entsteht ein P300, durch die Kombination von Reihe und Spalte ermittelt man dann den ausgewählten Buchstaben. [4] Diese Methode identifiziert den Buchstaben deutlich schneller.

Ein anderes EEG-Signal, das in den vergangenen Jahren immer mehr Aufmerksamkeit erhalten hat, weil es ermöglichte, viel schneller zu buchstabieren, ist das Visuell Evozierte Potential (VEP). Hinter diesem komplizierten Begriff versteckt sich ein einfaches Phänomen: die Reaktion des Bereichs im Gehirn, der Gesehenes verarbeitet (der visuelle Kortex, deutsch: Sehrinde), auf einen flackernden visuellen Reiz. Konkret werden hier vor allem frequenz-modulierte VEP (fVEP, meist steady-state VEP (SSVEP) genannt) und code-modulierte VEP (cVEP) unterschieden.

SSVEPs werden durch ein gleichmäßiges Flackern (Frequenz über 4 Hz [5]) zwischen zwei Farben, schwarz oder weiß ausgelöst. Der visuelle Kortex übernimmt dabei die Frequenz des Flackerns. Wenn jetzt jedem Buchstaben eine andere Frequenz zugewiesen wird, ist es einfach, aus dem EEG-Signal den richtigen Buchstaben auszulesen. Zu dieser Methode wird zum Beispiel im Cognitive Systems Lab der Uni Bremen geforscht.

Die Schwierigkeit für BCIs bei diesem Ansatz ist, dass einige Faktoren die Anzahl der Buchstaben einschränken, die zur selben Zeit angezeigt und unterschieden werden können. Denn zusätzlich zur eingesetzten Flacker-Frequenz können auch ganzzahlige Vielfache dieser Frequenz im visuellen Kortex generiert werden, also z.B. zusätzlich zu 5Hz auch 10Hz [6]. Setzt man also 5Hz und 10Hz als Flacker-Frequenzen ein, können beide im Gehirn eine Frequenz von 10Hz auslösen. Daher sollten die Frequenzen, die in einem SSVEP-basierten BCI verwendet werden, keine ganzzahligen Vielfachen voneinander sein. Gleichzeitig sollten die Frequenzen weit genug auseinander liegen, um sie mit Sicherheit voneinander unterscheiden zu können: 5 und 5,1Hz wären zum Beispiel wahrscheinlich durch Ungenauigkeiten der Messung recht schwierig auseinanderzuhalten. [7]

Hier kommt das cVEP ins Spiel: Dabei wird eine sogenannte m-Sequenz als Flacker-Stimulus genutzt. Eine m-Sequenz ist eine Bit-Sequenz (also eine Reihe von Einsen und Nullen), die die interessante Eigenschaft hat, dass sie nur minimal mit ihren zirkulär verschobenen Versionen korreliert.

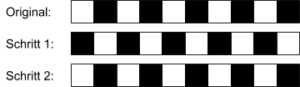

Um das zu erklären, ist in der folgenden Abbildung eine einfache Bit-Sequenz visualisiert, die keine m-Sequenz ist. Die weißen Felder symbolisieren Einsen, die schwarzen Felder Nullen. Einsen und Nullen in der Sequenz wechseln sich ab. Wird diese Sequenz um zwei Felder nach rechts verschoben und die überstehenden Felder an den Anfang gestellt (Schritt 2), sieht die Sequenz wieder haargenau aus wie das Original, die Korrelation ist maximal. Würden wir den Buchstaben A mit der Originalsequenz flackern lassen und den Buchstaben B mit der Sequenz nach Schritt 2, könnten wir die Buchstaben nicht auseinanderhalten. Dieses Beispiel ist also keine geeignete Bit-Sequenz.

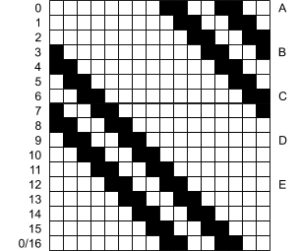

Bei einer m-Sequenz hingegen könnt ihr die Sequenz immer weiter verschieben und erst wenn ihr zur Ausgangsposition zurückkehrt, gleicht sich das Muster aus weiß und schwarz wieder, wie in der folgenden Darstellung der Verschiebungen einer 15-Bit Sequenz. Diese Eigenschaft kann man für einen BCI-Buchstabierer derart ausnutzen, dass dem Buchstaben ‚A‘ die originale m-Sequenz zugeordnet und diese dann für jeden weiteren Buchstaben verschoben wird. So hat jeder Buchstabe seine “ganz eigene” Flacker-Sequenz.

Um sicher zu gehen, dass die Sequenz auch wirklich dem richtigen Buchstaben zugeordnet werden kann, verschiebt man die Originalsequenz jeweils um 3-4 Positionen (also bei 60Hz um ca. 0.05s). Wenn der visuelle Kortex also mal ein bisschen schneller oder langsamer reagiert, wird nicht gleich der falsche Buchstabe ausgewählt.

Welcher Buchstabe geschrieben werden soll, wird dann mit einem Schablonenabgleich ermittelt. Dafür wird erst einmal eine Trainingsphase absolviert, in der dem/der NutzerIn die m-Sequenz etliche Male vorgespielt wird. Aus den EEG-Daten, die währenddessen erhoben werden, kann dann durch Mittelung der Durchläufe und ein spezielles statistisches Verfahren eine Schablone erstellt werden, welche das erwartete EEG-Signal abbildet. Beim anschließenden Buchstabieren werden die gemessenen EEG-Daten einfach mit der Schablone abgeglichen. Genau wie die m-Sequenz wird auch die Schablone verschoben, um zu ermitteln, bei welcher Verschiebung die Schablone am besten auf die Daten passt. Et voilà – der zur am besten passenden Verschiebung gehörige Buchstabe ist (wahrscheinlich) der ausgewählte Buchstabe.

Während eines Praktikums im Cognium habe ich genau diese Methode (anhand einer Studie von [8]) implementiert und getestet. Den Versuchspersonen wurden 25 Buchstaben (also A-Y) gezeigt. Und obwohl wir das zum ersten Mal ausprobierten, haben wir eine erstaunlich hohe Trefferquote erreicht: Der Schnitt meiner 6 Versuchspersonen lag bei ca. 70% richtig ermittelten aus 80 geschriebenen Buchstaben. Dabei haben wir zwei Frequenzen getestet: 72 und 144 Hz. Bei 4 der Versuchspersonen haben wir mit 72 Hz eine Trefferquote von über 80%, oft sogar über 90% erzielt, bei 3 Versuchspersonen klappte das auch mit 144 Hz – und das mit weniger als zwei Sekunden Daten pro Buchstabe!

Der Nachteil des cVEP gegenüber SSVEP ist, dass für jede(n) NutzerIn eine Trainingsphase durchgeführt werden muss, um die Schablone zu erstellen. Zusätzlich muss immer zu Beginn eines Durchlaufs der m-Sequenz ein Zeitstempel erstellt werden, da wir sonst nicht wüssten, ob die Schablone gar nicht (‚A‘) oder zum Beispiel zweimal (‚C‘) verschoben werden muss. Das macht den Aufbau für ein cVEP-basiertes BCI ein wenig komplexer.

Bis diese Methoden in die Praxis umgesetzt werden, muss (neben vielen anderen Fragen) allerdings noch geklärt werden, wie BCIs mobiler und kostengünstiger gestaltet werden können als in den meisten Studien derzeit praktiziert. Denn nur weil ich mittels meiner Gehirnströme kommunizieren möchte, bedeutet das nicht, dass ich immer einen Desktop-Computer, eine EEG-Kappe inklusive all der Kabelage und das restliche EEG-Equipment mit mir herumtragen möchte. Kabellose Alternativen zur herkömmlichen EEG-Kappe existieren bereits.

Bisher ist auch noch nicht geklärt, ob die vorgestellten VEP-basierten BCIs für CLIS-PatientInnen nutzbar sein werden. Denn dafür muss der auszuwählende Buchstabe fixiert werden. Für CLIS-PatientInnen, die nicht einmal mehr ihre Augen bewegen können, ist das natürlich nicht möglich. Reicht es also vielleicht, nur die Aufmerksamkeit auf den jeweiligen Buchstaben zu richten, die Buchstaben also nur “aus dem Augenwinkel” zu beobachten? Bisher wurde das nur unzureichend untersucht. Wahrscheinlich ist, dass für unterschiedliche NutzerInnen und Anwendungsbereiche verschiedene Techniken und Methoden zum Einsatz kommen werden, um den NutzerInnen optimal zu dienen.

Klar ist jedoch: Mit Gedankenlesen hat das alles wenig zu tun. Mit cleveren neurowissenschaftlichen, technischen, mathematischen und experimentellen Tricks und Erkenntnissen können wir dem Gehirn einige Informationen entlocken. Aber dazu muss der/die NutzerIn in aller Regel mitspielen. Wie vollständige Gedanken, wie wir sie ständig erleben, auf neuronaler Ebene entstehen und entschlüsselt werden können, davon haben wir nach wie vor kaum eine Idee…

Schreibe einen Kommentar